«Kling 3.0 está construido sobre una plataforma de entrenamiento profundamente unificada, lo que permite una entrada y salida multimodal verdaderamente nativas. Gracias a la integración fluida del audio y a un control avanzado de la coherencia, el modelo aporta una mayor sensación de realismo y cohesión al contenido generado», señaló la compañía en su anuncio.

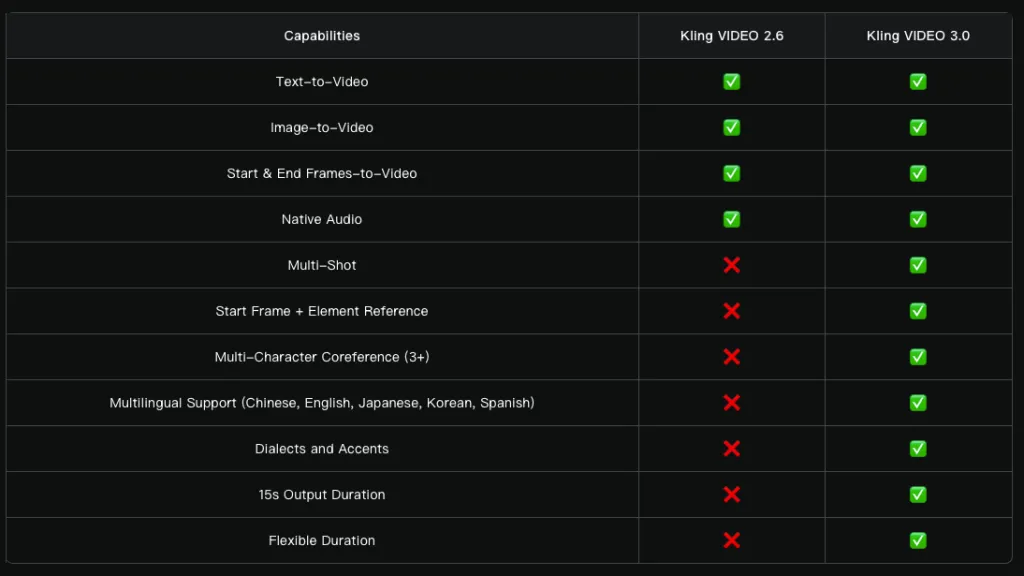

El modelo combina múltiples capacidades, entre ellas la conversión de texto, imágenes y materiales de referencia en video, así como la adición o eliminación de contenido y la modificación o transformación de clips existentes.

La duración de los videos se ha ampliado hasta 15 segundos. Otras mejoras incluyen un control de planos más flexible y una adhesión más precisa a los prompts. El realismo general también se ha incrementado, con movimientos de personajes más expresivos y dinámicos.

La nueva función Multi-Shot analiza los prompts para determinar la estructura de la escena y los tipos de plano, ajustando automáticamente los ángulos de cámara y la composición.

El modelo admite una amplia variedad de estilos de edición, desde los clásicos diálogos plano-contraplano hasta la narración paralela y escenas con voz en off.

«Ya no es necesario un laborioso proceso de corte y edición: una sola generación basta para crear un video cinematográfico y hacer accesibles formatos audiovisuales complejos a todos los creadores», afirma el comunicado.

Además de la generación estándar de imagen a video, Kling 3.0 admite múltiples imágenes de referencia y entradas de video como elementos de escena.

El modelo fija las características de los personajes, objetos y escenas. Independientemente del movimiento de cámara o del desarrollo narrativo, los elementos clave permanecen estables y coherentes a lo largo de todo el video.

El audio nativo también ha sido mejorado: la sincronización del habla con las expresiones faciales es más precisa y, en escenas de diálogo, los usuarios pueden especificar manualmente al hablante.

La lista de idiomas compatibles se ha ampliado e incluye chino, inglés, japonés, coreano y español, con una mejor gestión de dialectos y acentos.

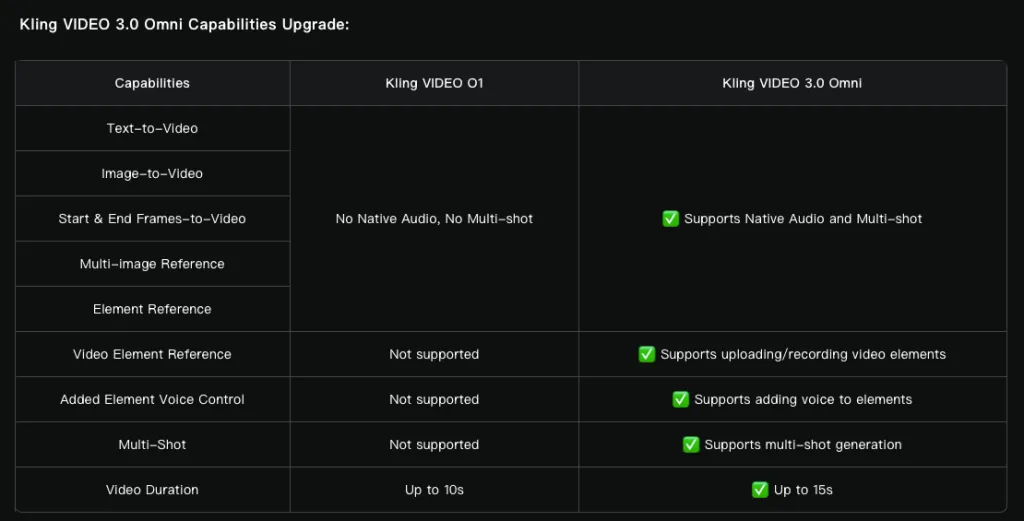

Además, el equipo actualizó su modelo multimodal O1 a Video 3.0 Omni.

Los usuarios pueden subir clips de audio con voz a partir de tres segundos para extraer una voz, o proporcionar clips de video de tres a ocho segundos de un personaje para capturar sus atributos principales.

Los competidores presionan a Sora

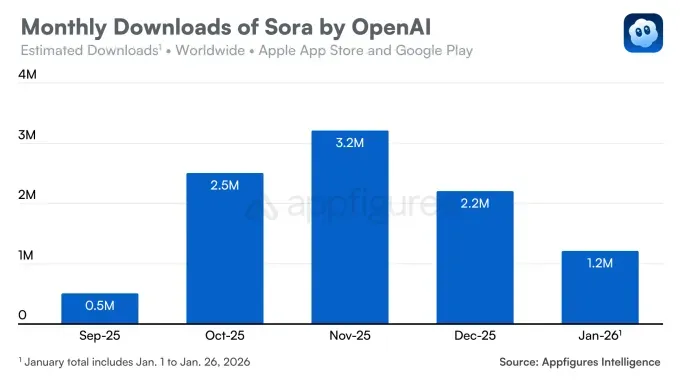

OpenAI presentó su modelo de generación de video Sora en febrero de 2024. La herramienta generó entusiasmo en redes sociales, pero su lanzamiento público no se produjo hasta diciembre.

Casi un año después, los usuarios obtuvieron acceso a funciones de generación de video a partir de texto, animación de imágenes y ampliación de videos.

La versión iOS de Sora, lanzada en septiembre, atrajo rápidamente la atención y superó las 100.000 descargas en su primer día. Alcanzó 1 millón de instalaciones más rápido que ChatGPT, a pesar de estar disponible solo por invitación.

Sin embargo, la tendencia pronto se revirtió. En diciembre, las descargas cayeron un 32% intermensual, y el descenso continuó en enero, con 1,2 millones de instalaciones.

La desaceleración se debió a varios factores. En primer lugar, la competencia se intensificó con el modelo Nano Banana de Google, que reforzó la posición de Gemini. Sora también enfrenta presión por parte de Meta AI y su función Vibes, mientras que el modelo Gen-4.5 de Runway elevó el listón en pruebas independientes.

En segundo lugar, OpenAI se enfrentó a problemas de derechos de autor. Los usuarios generaron videos con personajes populares como Bob Esponja y Pikachu, lo que obligó a la empresa a endurecer las restricciones.

En diciembre, la situación se estabilizó tras un acuerdo entre OpenAI y Disney, que permitió a los usuarios generar videos con personajes del estudio. Sin embargo, esto no se tradujo en un nuevo crecimiento de las descargas.

ES

ES  EN

EN