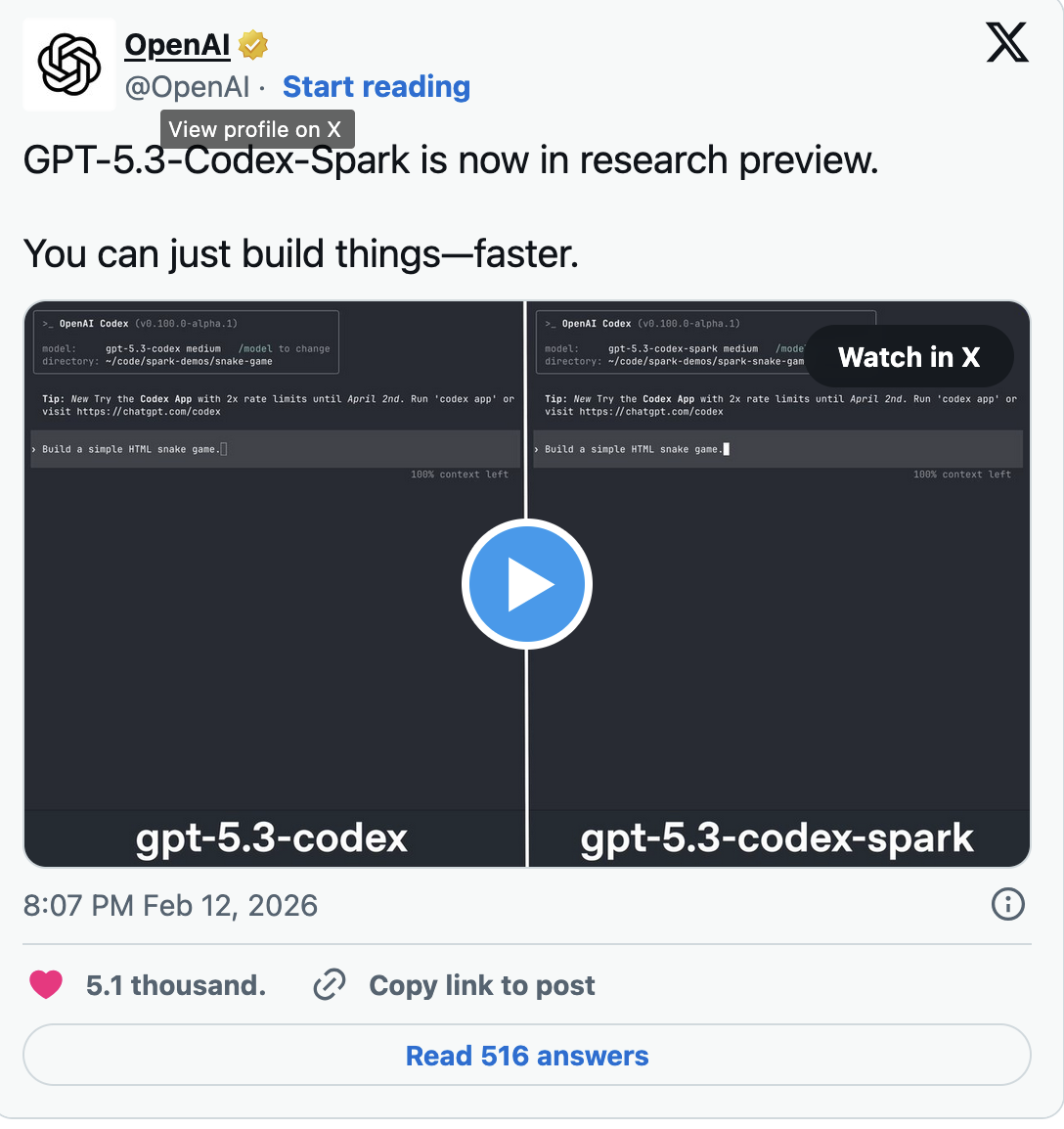

GPT-5.3-Codex-Spark se presenta como una variante reducida del modelo GPT-5.3 Codex, presentado en febrero, y está optimizada para una inferencia más rápida. Para lograrlo, la startup utiliza un chip especializado de su socio de hardware, Cerebras.

Las dos compañías anunciaron su asociación en enero.

«La integración de Cerebras en nuestra infraestructura de cómputo tiene como objetivo hacer que las respuestas de la IA sean significativamente más rápidas», señaló OpenAI en ese momento.

La compañía describe el chip Spark como el “primer hito” de la asociación.

El procesador está diseñado para un funcionamiento de alta velocidad en tiempo real y se basa en Wafer Scale Engine 3 de Cerebras, la tercera generación de los megachips a escala de oblea de la empresa, que cuentan con cuatro billones de transistores.

OpenAI define la nueva herramienta como un «impulsor diario de la productividad» que facilita la creación rápida de prototipos, mientras que la versión original de GPT-5.3 Codex está pensada para tareas más largas y que requieren mayores recursos.

En su comunicado oficial, OpenAI subrayó que Spark fue diseñado para ofrecer la menor latencia posible en Codex.

«Codex-Spark es el primer paso hacia un Codex que opere en dos modos complementarios: colaboración en tiempo real para iteraciones rápidas y tareas prolongadas que requieren razonamiento profundo», afirmó la compañía.

ES

ES  EN

EN