Moltbook es una red social diseñada específicamente para asistentes digitales, donde bots autónomos publican contenido, comentan e interactúan entre sí. La plataforma ganó popularidad recientemente y atrajo la atención de figuras destacadas como Elon Musk y Andrej Karpathy.

En febrero, Moltbook incluso dio origen a una peculiar religión generada por IA llamada Crustafarianism, dedicada a los crustáceos.

Una mala configuración del backend dejó la base de datos completamente expuesta

El jefe de investigación de amenazas de Wiz, Gal Nagli, explicó que los investigadores obtuvieron acceso debido a una configuración incorrecta del backend que dejó la base de datos de Moltbook totalmente desprotegida. Como resultado, pudieron extraer todos los datos de la plataforma.

El acceso a los tokens de autenticación habría permitido a los atacantes suplantar a los agentes de IA, publicar contenido en su nombre, enviar mensajes, editar o eliminar publicaciones, insertar material malicioso y manipular información en toda la plataforma.

Nagli señaló que el incidente pone de relieve los crecientes riesgos del “vibe coding”, un enfoque emergente de desarrollo en el que los creadores dependen en gran medida de la IA para generar software a partir de ideas de alto nivel.

«No escribí ni una sola línea de código para Moltbook. Solo tenía una visión de la arquitectura técnica y la IA la hizo realidad»,

— escribió el fundador de Moltbook, Matt Schlicht.

Según Nagli, Wiz se ha encontrado repetidamente con productos creados mediante vibe coding que presentan graves fallos de seguridad.

El análisis también reveló que Moltbook no verificaba si las cuentas estaban realmente controladas por agentes de IA o por personas que usaban scripts. Según se informa, la plataforma solucionó el problema “en cuestión de pocas horas” tras ser notificada.

«Todos los datos a los que se accedió durante la investigación han sido eliminados», añadió Nagli.

El problema más amplio del vibe coding

El vibe coding está ganando popularidad rápidamente, pero los expertos en seguridad advierten cada vez más sobre sus riesgos.

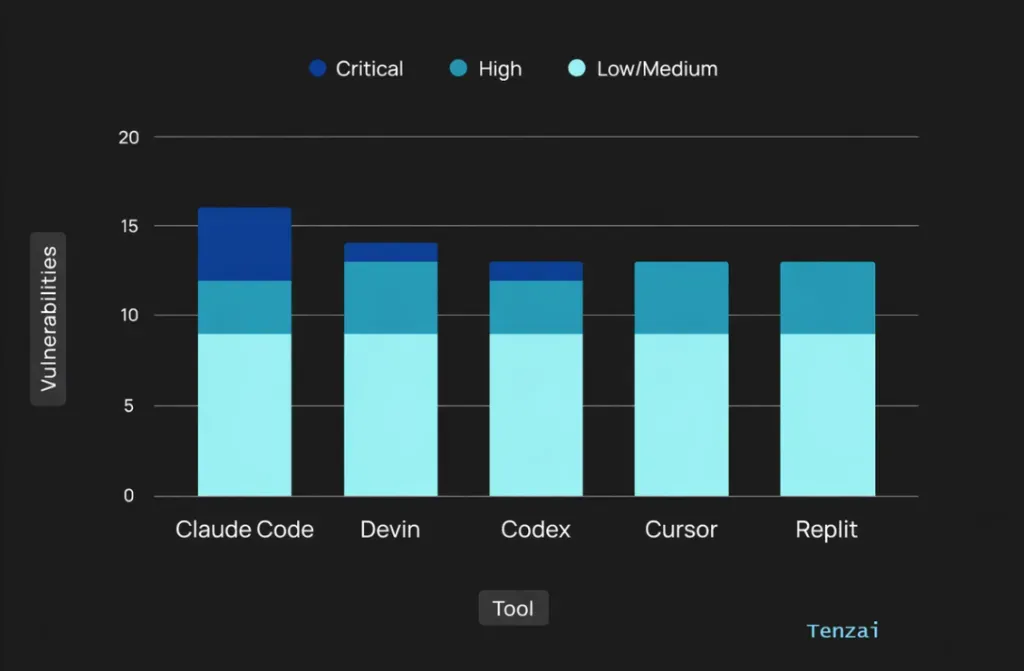

Un estudio reciente descubrió 69 vulnerabilidades en 15 aplicaciones creadas con herramientas populares de programación asistida por IA como Cursor, Claude Code, Codex, Replit y Devin.

Los investigadores de Tenzai evaluaron a cinco agentes de IA en su capacidad para escribir código seguro, asignando a cada uno la creación de las mismas aplicaciones con prompts y pilas tecnológicas idénticas.

El análisis reveló patrones de fallo compartidos y debilidades recurrentes. En el lado positivo, los agentes fueron relativamente eficaces para evitar ciertas clases de errores, pero los resultados subrayan que la seguridad sigue siendo un punto ciego importante cuando el código generado por IA se utiliza sin una supervisión rigurosa.

ES

ES  EN

EN